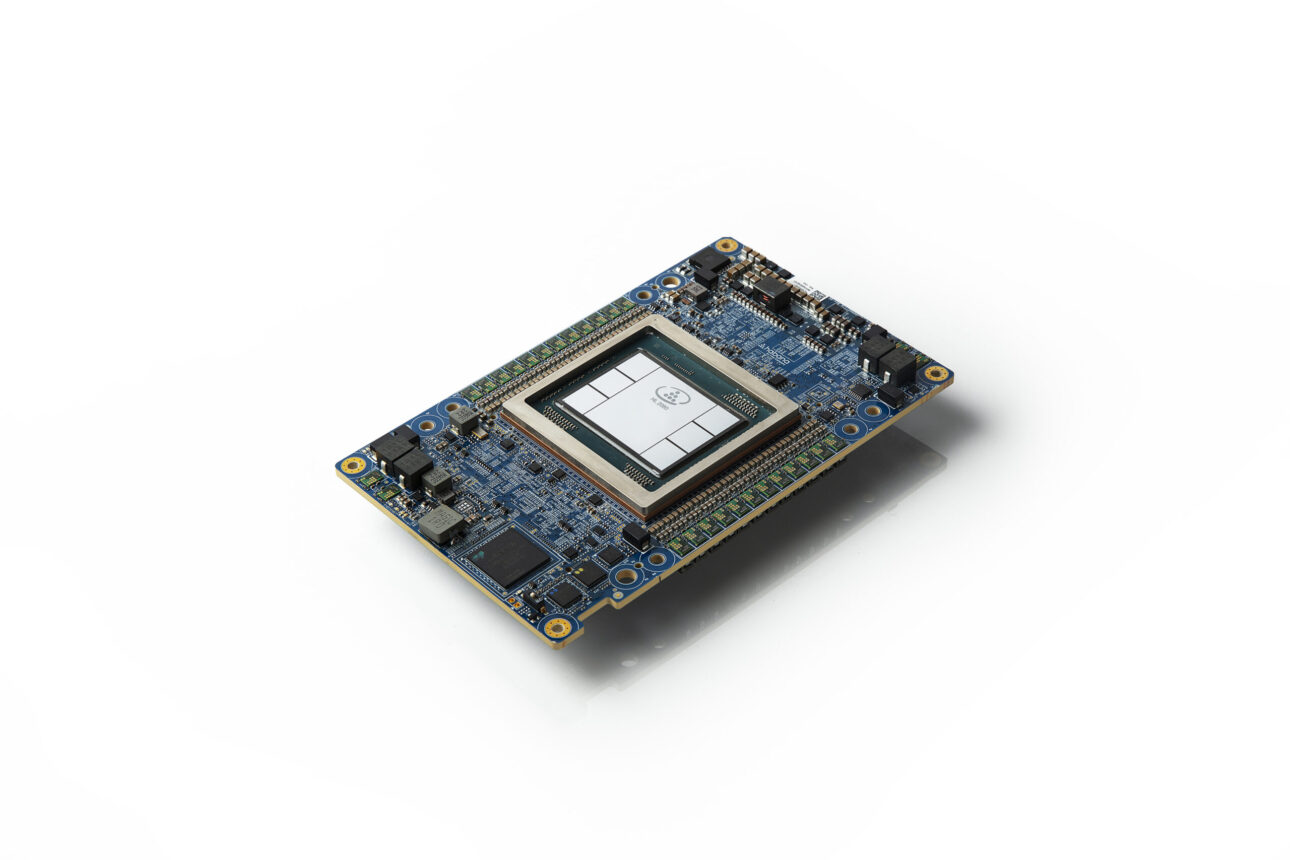

Segundo-Gen Habana Gaudi2 supera Nvidia A100

Novidades: A Intel anunciou hoje que seus processadores de aprendizado profundo Habana® Gaudi®2 de segunda geração superaram a submissão A100 da Nvidia para o tempo de trem de IA no benchmark da indústria MLPerf. Os resultados destacam os principais tempos de treinamento nos modelos de visão (ResNet-50) e linguagem (BERT) com o processador Gaudi2, que foi revelado em maio no evento Intel Vision.

“Estou empolgado em entregar os excelentes resultados da MLPerf com a Gaudi 2 e orgulhoso da conquista da nossa equipe para fazê-lo apenas um mês após o lançamento. Oferecer o melhor desempenho da classe em modelos de visão e idiomas trará valor aos clientes e ajudará a acelerar suas soluções de aprendizagem profunda de IA.”–Sandra Rivera, vice-presidente executiva da Intel e gerente geral do Datacenter e grupo de IA

Por que isso importa: Com a plataforma Gaudi da Habana Labs, a equipe de data center da Intel se concentrou em tecnologias de processadores de deep learning, permite que cientistas de dados e engenheiros de aprendizado de máquina acelerem o treinamento e construam modelos novos ou migrem com apenas algumas linhas de código para desfrutar de maior produtividade, além de custos operacionais mais baixos.

O que isso mostra: Gaudi2 oferece avanços dramáticos no time-to-train (TTT) em relação à primeira geração da Gaudi e permitiu que a submissão MLPerf de maio de 2022 da Habana superasse o A100-80G da Nvidia para oito aceleradores em modelos de visão e linguagem. Para o ResNet-50, gaudi2 oferece uma redução de 36% no tempo de trem em comparação com o TTT da Nvidia para A100-80GB e uma redução de 45% em comparação com um envio de 8 aceleradores A100-40GB pela Dell para ResNet-50 e BERT.

Métricas publicadas pela MLCommons, junho de 2022, https://mlcommons.org/en/training-normal-20/

Comparado com gaudi de primeira geração, Gaudi2 consegue uma aceleração de 3x em throughput de treinamento para ResNet-50 e 4,7x para BERT. Esses avanços podem ser atribuídos à transição para o processo de 7 nanômetros a partir de 16 nm, triplicando o número de Núcleos de Processador Tensor, aumentando a capacidade de computação do motor GEMM, triplicando a capacidade de memória de alta largura de banda no pacote, aumentando a largura de banda e dobrando o tamanho do SRAM. Para modelos de visão, gaudi2 tem uma nova característica na forma de um mecanismo de mídia integrado, que opera de forma independente e pode lidar com todo o tubo de pré-processamento para imagens compactadas, incluindo aumento de dados necessário para o treinamento de IA.

Sobre o desempenho fora da caixa: O desempenho de ambas as gerações de processadores Gaudi é alcançado sem manipulações especiais de software que diferem da pilha de software comercial fora da caixa disponível para os clientes habana.

Comparando o desempenho fora da caixa obtido com o software comercialmente disponível, as seguintes medidas foram produzidas pela Habana em um servidor comum de 8 GPU versus o servidor de referência HLS-Gaudi2. O throughput de treinamento foi derivado com dockers TensorFlow da NGC e de repositórios públicos Habana, empregando os melhores parâmetros de desempenho conforme recomendado pelos fornecedores (precisão mista usada em ambos). O throughput do tempo de treinamento é um fator-chave que afeta a convergência do tempo de treinamento resultante:

Configurações de teste para gráficos fornecidas na seção “A impressão pequena”.

Configurações de teste para gráficos fornecidas na seção “A impressão pequena”.

Além das conquistas da Gaudi2 observadas no MLPerf, a primeira geração da Gaudi apresentou forte desempenho e impressionante escala quase linear na ResNet para submissões Gaudi de 128 aceleradores e 256 aceleradoras que suportam o dimensionamento do sistema de alta eficiência para os clientes.

“A Gaudi2 oferece um desempenho claro de treinamento de liderança, comprovado pelos resultados mais recentes do MLPerf”, disse Eitan Medina, diretor de operações da Habana Labs. “E continuamos a inovar em nossa arquitetura e software de treinamento de aprendizagem profunda para fornecer as soluções de treinamento de IA mais competitivas.”

Sobre o MLPerf Benchmarks: A comunidade MLPerf tem como objetivo projetar benchmarks justos e úteis que forneçam “medições consistentes de precisão, velocidade e eficiência” para soluções de aprendizado de máquina. Eles foram criados por líderes de IA da academia, laboratórios de pesquisa e da indústria que decidiram sobre benchmarks e definiram um conjunto de regras rígidas que garantem uma comparação justa entre todos os fornecedores. O benchmark MLPerf é o único benchmark confiável para a indústria de IA devido ao seu conjunto explícito de regras, que permitem uma comparação justa em tarefas de ponta a ponta. Além disso, as submissões do MLPerf passam por um processo de revisão por pares durante um mês, que valida ainda mais os resultados relatados.

Mais Contexto:Habana MLPerf Results Blog | Resultados do MLPerf

A pequena impressão:

Configuração de teste para comparação de desempenho resNet-50

A100-80GB: Medido em abril de 2022 por Habana na instância do Azure Standard_ND96amsr_A100_v4 usando um único A100-80GB usando docker TF 22.03-tf2-py3 do NGC (optimizer=sgd, BS=256)

A100-40GB: Medido em abril de 2022 por Habana no DGX-A100 usando um único A100-40GB usando tf docker 22.03-tf2-py3 da NGC (optimizer=sgd, BS=256)

V100-32GB:Medida em abril de 2022 por Habana em p3dn.24xlarge usando v100-32GB único usando tf docker 22.03-tf2-py3 de NGC (optimizer=sgd, BS=256)

Gaudi2: Medido em maio de 2022 por Habana no sistema Gaudi2-HLS usando gaudi2 único usando o docker SynapseAI TF 1.5.0 (BS=256)

Os resultados podem variar.

Configuração de teste para comparação de desempenho bert

A100-80GB: Medido em abril de 2022 por Habana na instância do Azure Standard_ND96amsr_A100_v4 usando um único A100-80GB com docker TF 22.03-tf2-py3 da NGC (Fase-1: Seq len=128, BS=312, accu steps=256; Fase-2: seq len=512, BS=40, accu steps=768)

A100-40GB: Medido em abril de 2022 por Habana no DGX-A100 usando um único A100-40GB com docker TF 22.03-tf2-py3 da NGC (Fase-1: Seq len=128, BS=64,

accu passos=1024; Fase-2: seq len=512, BS=16, accu steps=2048)

V100-32GB: Medido em abril de 2022 por Habana em p3dn.24xlarge usando v100-32GB único com tf docker 21.12-tf2-py3 de NGC (Fase-1: Seq len=128, BS=64, accu steps=1024; Fase-2: seq len=512, BS=8, accu steps=4096)

Gaudi2: Medido em maio de 2022 por Habana no sistema Gaudi2-HLS usando gaudi2 único com docker SynapseAI TF 1.5.0 (Fase-1: Seq len=128, BS=64, accu steps=1024; Fase-2: seq len=512, BS=16, accu steps=2048)

Os resultados podem variar.

Laboratórios Habana. Habana, logotipo Habana, Gaudi e SynapseAI são marcas comerciais da Habana Labs.